Hlavní zájem teorie informace jako jednoho z pilířů kybernetiky se týká přenosnosti zpráv sdělovacím prostředím (říká se mu »kanál«), kde jsou nějak rušeny šumem a jde o to odstranit nebo alespoň minimalizovat jeho následky. Vědci se však v poslední době dostávají mnohem dál a součástí výzkumných programů zaměřených na analýzy zdrojů jsou dnes i delfíni.

Většina z nás už o nějakém měření informace slyšela. Paměť počítače nebo kapacita internetové trasy se měří v bitech a bytech. Tam jde ale o měření záznamu informace – kolik místa spotřebuje. Informační obsah sdělení je něco jiného, co s délkou zprávy jistě přímo souviset nebude; všichni známe dlouhé, nic neříkající texty a na druhé straně krátká sdělení, která dokázala změnit svět. Na druhé straně nám nevadí mluvit o tom, že se informace (třeba rušením rádiového provozu) ztrácí, a tím připouštíme, že se o jejím množství uvažovat dá. Jak ale poznat, je-li více informace ve větě »Hrdliččin zval ku lásce hlas« nebo »Večeři máš v lednici«? Důvtipný nápad přinesl Claude Elwood Shannon, americký matematik a elektrotechnik, který se přenosem zpráv teoreticky zabýval. Došel k závěra, že zpráva nám přinese tím víc informace, čím víc nás »překvapí«. Poněkud přesněji: informace obsažená ve zprávě bude nepřímo úměrná její pravděpodobnosti. Protože v šifrovaných vojenských zprávách, o které hlavně šlo, se nevyskytuje hrdliččin hlas, ale spíše nesrozumitelné posloupnosti znaků nebo jejich skupin, bylo praktické vztáhnout pravděpodobnostní definici informace na jednotlivé znaky.

Šifry a morseovka

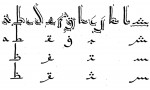

Pro zdroj zpráv jako celek je pak důležitá průměrná informace připadající na každý jím produkovaný znak. Nazývá se entropie a shoda s odpovídajícím fyzikálním termínem není náhodná – také informační entropie charakterizuje neuspořádanost. Čím je zdroj zpráv chaotičtější (všechny znaky jsou zhruba stejně pravděpodobné), tím je jeho entropie větší. Naopak entropie klesá, rostou-li rozdíly mezi pravděpodobnostmi znaků. Mimochodem – toho, že písmena mají různou pravděpodobnost výskytu, si všimli už někdy v 10. století arabští učenci při studiu koránu a využili toho při luštění šifrovaných textů: nejčastějšímu znaku v šifře přiřadili nejčastější písmeno, druhému druhé nejčastější, atd., a když byl šifrovaný text dost dlouhý, aby se pravděpodobnosti písmen mohly projevit v jejich četnosti, zpravidla se povedlo šifru rozlousknout. Četností písmen v angličtině si zase všiml pan Morse, když sestavoval svoji abecedu z teček a čárek, a zdá se, zeji dost respektoval. Na druhé straně se traduje, že podmíněných pravděpodobností písmen (zase v angličtině) si byli vědomi i konstruktéři prvních psacích strojů. Jejich mechanika byla pomalá a při rychlém sledu úhozů by si klapky překážely. Proto prý na klávesnici dali písmena, která po sobě často následují, daleko od sebe.

V luštění pomáhá podmíněná pravděpodobnost

Pro zkoumání zdrojů zpráv jsou důležité i takzvané podmíněné pravděpodobnosti a z nich odvozené informace. Jde v nich o to, že pravděpodobnost znaku může hodně záviset (a také často závisí) na tom, po kterém znaku, či kterých znacích, následuje. Po skupině písmen »stů« v češtině může následovat jen l, neboj, nebo ještě n (stůně). Také podmíněné pravděpodobnosti byly při luštění šifer a starých písem využity. Teorie informace si, byť okrajově a trochu mimo hlavní proud zájmu (hlavně ve svých počátcích trochu fascinovaných obzory, které nový vědní obor otevřel), všímala i některých dalších jevů spojených s produkováním a přenosem zpráv. Například odlišnostmi informačních charakteristik mezi různými jazyky a výskytem některých dalších jazykových jevů, jako jsou koncovky slov či slabičnost písma, které se hodí při studiu starých jazyků a písem. Nebo i pravidelnostmi v posílání zpráv. Ke zdolání německého šifrovacího stroje Enigma (ještě před vznikem teorie informace), například, přispěla vojenská záliba v ustálených formulacích, vysílání zpráv jistého typu (počasí, kde se dala jistě očekávat jistá slova) vždy ve stejnou denní dobu a některé další pravidelnosti. Těmto otázkám není věnována speciální část teorie informace, mohou se ale projevit v pravděpodobnostech znaků a skupin znaků, o kterých tady už byla řeč.

Jakou hodnotu má entropie?

K zajímavým poznatkům vedly vědce vlastnosti entropie. Už jsme si řekli, že největší entropii (tedy jakousi míru nepořádnosti) vykazují zdroje, ve kterých jsou všechny znaky stejně pravděpodobné. U angličtiny s jejími 27 znaky má taková entropie hodnotu 4,75. Víme ale, že v ní nejsou všechna písmena stejně pravděpodobná, což poněkud snižuje její »nepořádnost« a vnáší do jazyka náznak řádu, takže »nepodmíněná« entropie angličtiny je ve skutečnosti jen 4,03. Ohled na to, po kterém znaku písmeno následuje, zase trochu diferencuje mezi (podmíněnými) pravděpodobnostmi znaků a tím dále snižuje entropii na hodnotu 3,32. Když nás v podmíněné pravděpodobnosti zajímají ne jen jedno, ale dvě poslední písmena, sníží se entropie na hodnotu 3,1. Budiž poznamenáno, že hledání podmíněných pravděpodobností je pro delší »minulost« hodně pracné. Nicméně se pro angličtinu podařilo ověřit, že příslušné entropie klesají (čím dál pomaleji) a že se pro hodně dlouhé předchozí úseky zpráv ustalují někde blízko hodnoty 1. Pro češtinu se autorovi nepodařilo tak propracovaná data najít, budou ale v zásadě vykazovat podobné vlastnosti (jen pro začátek: pro stejně pravděpodobná písma – je jich 42 – má čeština entropii 5,39, při respektování jejich skutečných pravděpodobností už klesá na 4,67).

Dorozumíme se s mimozemšťany?

To, co bylo řečeno o postupném poklesu podmíněných entropií, platí pro komunikaci v něčem, co bychom nazvali lidské jazyky. Neplatí to o signálech. Vřískání opiček nebo štěkání našeho pejska, případně posloupnost dopravních značek na silnici, má poměrně stálou entropii bez ohledu na to, jak dlouhou minulost bereme v úvahu, když to zkusíme s podmíněnými pravděpodobnostmi. Vědci ale našli jednu výjimku – entropie delfíních signálů s délkou podmíněnosti klesá podobně jako u lidských jazyků. To si zaslouží pozornost a obdivovatelé delfínů to ji stě ocení. Z trochu jiného pohledu, jestli se jednou nakrásně povede zachytit signály z vesmíru, může být chování podmíněných entropií zachyceného zdroje docela dobrým indikátorem, že je to opravdu pokus o komunikaci a ne další typ pulsaru (rychle rotující hvězdy vysílající pravidelné elektromagnetické záblesky – pulsy) nebo jiný přirozený jev. Vtipné by bylo, kdyby nám ufoni jaksi »na rozehřátí« vysílali nějaké signály, něco jako dopravní značky. Teorie informace řeší hlavně problémy spojené s přenosem zpráv, jejich kódováním a ochranou před šumem. Vyznat se v jejich zdrojích, to je pro celou teorii vlastně jen první krok, na který všechno to další navazuje. Nicméně i to nakonec nabízí překvapivě silné nástroje pro zacházení s informacemi.

ZVÍŘATA NEMLUVÍ, JEN SIGNALIZUJÍ

Často se v životě setkáváme s »abecedami« trochu jiného typu. Každý znak v nich, říká se jim signály, je zprávou sám o sobě – představme si třeba dopravní značky. Jejich seřazení pak už žádnou další informaci v podstatě nenese. Celá alej dopravních značek neříká nic víc než souhrn »zpráv« nesených každou z nich izolovaně. Tím se liší od obvyklých lidských jazyků, kde uspořádání znaků (písmen, hlásek) hraje podstatnou roli. Přirozeně – » děmm rt« je něco jiného než »mám tě rád« a také reakce na ně se může dramaticky lišit. Je známo, že komunikace zvířat je výměna signálů, nikoli »řeč« v lidském slova smyslu (snad až na komunikaci delfínů). Váš pejsek, i když při tom vypadá sebechytřeji, si s vámi nepovídá – jen signalizuje. V podmíněných pravděpodobnostech a v poklesu z nich vypočítaných entropií se projevuje právě vliv pořadí znaků jako nositele informace.

PRO TY, KDO SNÁŠEJÍ SLOVO LOGARITMUS

Je-li z znak z nějaké abecedy Z a p(z) pravděpodobnost jeho výskytu ve zprávách ze sledovaného zdroje, pak bude informace, kterou nese, úměrná převrácené hodnotě 1/p(z). Je přirozené chtít, aby se informace, nesená dvěma nezávislými znaky, sčítaly, a přitom z teorie pravděpodobnosti víme, že pravděpodobnosti nezávislých jevů se násobí. Matematik, který se potřebuje dostat od součinů k součtům, obvykle sáhne po logaritmech. Udělal to i Claude Shannon, takže informace nesená znakem z je definována jako log2(1/p(z)), což je -log2(p(z)). Za základ logaritmů bylo zvoleno číslo 2 částečně s ohledem na dvojkovou abecedu, při přenosu zpráv hojně používanou. Termínem entropie zdroje je pak označován průměr z informací znaků abecedy Z, kterou používá. Počítá se tedy podle vzorce l-p(z). log2(p(z)). Pravděpodobnost každého znaku obvykle záleží na tom, který znak (nebo které znaky) se vyskytly před ním. Podmíněnou pravděpodobnost znaku z za podmínky, že před ním byl vyslán znaky, označujeme obvykle p(zy) a je přirozené definovat podmíněnou informaci znaku z, jestliže před ním bylo vysláno y, jako -log2(p(zy)). Z podmíněné informace se dá spočítat i podmíněná entropie zdroje. Každého jistě napadne, že stejně se dá postupovat pro delší skupiny předcházejících znaků.

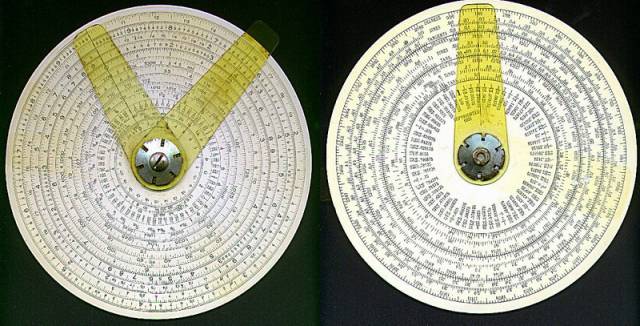

MORSEOVA ABECEDA

Nemá, na rozdíl od toho, co se učí skauti, dvě písmena, ale tři: tečku, čárku a mezeru. Samuel Finlay Breese Morse (1791-1872) byl povoláním malíř (nikoli pokojů, ale obrazů), byl ale zřejmě duše hloubavá a přemýšlel, jak usnadnit telegrafii, která tehdy byla čerstvým vynálezem. Skupiny teček a čárek nepřidělil písmenům jen tak libovolně. Jeden z jeho příbuzných (snad švagr) prý byl tiskař. Ti tehdy sázeli hotová písmena ze zásobníků (kas), kde je měli rozděleny do přihrádek. Pan Morse si všiml, že švagr nemá všechny přihrádky stejně velké -některých písmen potřeboval víc – a podle velikosti oněch přihrádek přidělil písmenům tečky a čárky. Vypadá to pravděpodobně – nejčastější písmeno angličtiny e má jednu tečku, druhé t má jednu čárku, a tak to jde dál. Více méně – další v pořadí je o a to se třemi čárkami moc dohromady nejde. Následují a, n a i a jejich morseovkové protějšky jsou už zase krátké. Asi měl švagr v kase trochu nepořádek.

CO JE TO LGM?

Jde o v astronomii užívanou zkratku pro velmi rychlé pulsary. Znamená vlastně Little Green Men (Malí Zelení Mužíčci) a žertovně připomíná první dojem objevitelů rychlých pulsarů, že tak vysoká frekvence impulsů snad musí mít umělý původ. Právě informačně teoretická analýza (přílišná pravidelnost a tím »neinformačně« nízká entropie) potvrdily skeptické pochybnosti.

PRAVDĚPODOBNOSTI ZNAKŮ V RŮZNÝCH JAZYCÍCH

Pravděpodobnosti znaků – písmen – se v různých jazycích liší. Pro češtinu a angličtinu, které obě užívají podobnou abecedu (angličtina má 27 písmen, čeština 42, přičemž ú a ů se považují za jeden znak a v obou jazycích je za samostatný znak považována mezera mezi slovy), je nejpravděpodobnější znak právě mezera (v češtině má ale pravděpodobnost 0,163 a v angličtině 0,182) a na druhém místě je e (v češtině 0,073, v angličtině 0,107). Na třetím místě už ale má čeština o (0,068) a angličtina t (0,086). Přitom v angličtině je o na 4. místě (0,067) a naopak v češtině je t až sedmé (0,039). Na druhém konci četnostních tabulek je v češtině x (0,001) aó,w,q (pod 0,001), zatímco v angličtině jsou na konci x, j, q, z (všechny 0,001). Ohled na předchozí znak může pravděpodobnostmi hodně zamíchat. Zůstaňme u češtiny. Tak například je v ní vyloučeno, aby po ň následovalo y, ý, i, í, e, ě, é, jejich podmíněná pravděpodobnost za podmínky, že jim předcházelo ň, je tedy nulová (pan Jeňýk Pacák promine – potvrzuje pravidlo), ačkoliv ta nepodmíněná je dohromady 0,173. Naopak, p je samo o sobě dost nenápadné (má pravděpodobnost 0,027 a je v pořadí až patnácté). Na začátku slova (po prázdném znaku) je ale ze všech nejpravděpodobnější, s pravděpodobností 0,147.